サイバーセキュリティニュース: AI セキュリティ強化のための専門家のアドバイス

企業が AI ブームに沸く中、AI システムの保護はサイバーセキュリティ部門にとって重要な優先事項かつ最大の難関となっています。彼らは新しく発展し続ける領域の専門知識の獲得に苦戦しています。 このサイバーセキュリティニュース特別版では、2025 年現在、 AI セキュリティに関して専門家が提供しているベストプラクティスとインサイトのいくつかをご紹介します。

見逃していた場合に備え、サイバー攻撃から AI システムを守るための新しいガイダンスを以下にご紹介します。

1 - AI データを制限するためのベストプラクティス

組織が AI システムを動かす機密データを保護する方法に関する推奨事項をお探しでしょうか。その場合は、オーストラリア、ニュージーランド、英国、米国のサイバー機関が 5 月に発表した新たなベストプラクティスを確認しましょう。

「このガイダンスは、AI システムを業務に使用している組織を主な対象とし、機密データや知的財産、ミッションクリティカルなデータの保護に焦点を当てたものです」と「AI Data Security: Best Practices for Securing Data Used to Train & Operate AI Systems (AIデータセキュリティ: AI システムのトレーニングや運用に利用されるデータの保護に関するベストプラクティス)」と題した文書に記載されています。

同文書では「この情報シートに説明されている原則は、AI データを保護し、AI を活用した成果の信頼性と正確性を保証するための強固な基盤を提供するものです」とも述べられています。

作成に携わった機関は、 このガイダンス草案を作成することで以下の 3 つの目標を達成することを目指しています。

- AI システムの開発、テスト、デプロイに伴うデータセキュリティリスクに警鐘を鳴らす

- AI のライフサイクル全体にわたってデータを保護するためのベストプラクティスをサイバー防衛の担当者に提供する

- 堅牢なデータセキュリティ技術とスマートなリスク軽減戦略の採用を推進する

以下に、22 ページに及ぶ包括的な文書に記載されている主なベストプラクティスを簡単にご紹介します。

- スマートなソース: AI モデルのトレーニングには信頼できるデータソースを使用し、出所追跡機能を使用してデータの起源を追跡します。

- ガードの完全性: AI データの保存時や送信時には、チェックサムと暗号化ハッシュを使用してデータを保護します。

- 改ざん防止: デジタル署名を導入し、AI データの不正な改ざんを防ぎます。

AI データセキュリティの詳細については、Tenable の以下のリソースをご覧ください。

- 「クラウドデータと AI リソースの保護が決め手になるクラウドセキュリティ態勢の要塞化」(ブログ)

- Tenable クラウド AI リスクレポート 2025 (レポート)

- 「クラウド環境の AI セキュリティリスクなんて怖くない!?」(ブログ)

- 「Tenable クラウド AI リスクレポート 2025: クラウドでの、より安全な AI モデルの構築を支援」 (オンデマンドウェビナー)

- 環境内のエクスポージャーを把握: Is Your Cloud Data Secure in the Age of AI? (環境内のエクスポージャーを把握: AI 時代のクラウドデータは安全か) (オンデマンドウェビナー)

2 - NIST が AI システムへの攻撃を分類し、軽減策を提示

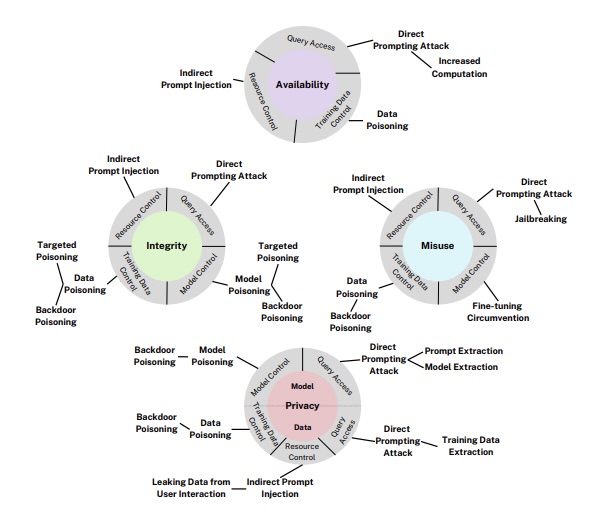

例えば、米国の 国立標準技術研究所 (NIST) もまた、AI システムを脅かすサイバーリスクに対処できるよう、組織の支援に踏み出しています。 3 月、NIST は昨年初めて発行した「Adversarial Machine Learning: A Taxonomy and Terminology of Attacks and Mitigations (敵対的機械学習: 攻撃と軽減の分類および専門用語) (NIST AI 100-2) 」を更新しました。

127 ページに及ぶこの膨大な報告書には、以下のような内容が含まれています。

- 敵対的機械学習 (AML) 攻撃の詳細な分類。これには予測 AI システムと生成 AI システムの両方に対する回避攻撃、ポイズニング攻撃、プライバシー攻撃、および学習手法を標的とする AML 攻撃が含まれます

- AML 攻撃に対して取り得る軽減策と、その限界についての現実的な考察

- 標準化された AML 専門用語の索引つき用語集

「さまざまな応用領域で AI や機械学習が大きく進歩しているにもかかわらず、これらのテクノロジーは依然として攻撃に対して脆弱です」と NIST の声明には記載されています。 「システムが重要度の高い領域に依存しており、敵対的な攻撃を受けた場合、攻撃の結果はより悲惨なものになります」

例えば、生成 AI システムに対するサプライチェーン攻撃に対抗するための NIST の推奨事項は以下のとおりです。

- データの完全性の検証: ウェブからのデータを使用して AI モデルをトレーニングする前に、データが改ざんされていないことを確認してください。 基本的な完全性チェックでは、データの提供元が暗号ハッシュを公開し、ダウンロードした人がトレーニングデータを検証します。

- 汚染をフィルタリングで除去: データのフィルタリングを導入し、汚染されたデータサンプルを除去します。

- 弱点をスキャン: モデル成果物の脆弱性診断を実施します。

- バックドアの特定: 機械的解釈可能性手法を使用して、バックドアの特徴を特定します。

- レジリエンスを考慮した設計: モデル攻撃の影響を軽減するように、生成 AI アプリケーションを構築します。

生成 AI システムに対する攻撃の分類方法

(出典: NIST による「Adversarial Machine Learning: A Taxonomy and Terminology of Attacks and Mitigations (敵対的機械学習: 攻撃と軽減の分類および専門用語)」 報告書、2025 年 3 月)

この報告書は、主に AI システムの設計、開発、導入、評価、管理を行う担当者を対象として書かれています。

AI システムをサイバー攻撃から保護する方法の詳細については、以下をご覧ください。

- Understanding the risks - and benefits - of using AI tools (AI ツールを使用するリスクとメリットを理解する) (英国 NCSC)

- Hacking AI? Here are 4 common attacks on AI (AI のハッキング: AI に対する 4 つの一般的な攻撃) (ZDNet)

- 「Best Practices for Deploying Secure and Resilient AI Systems (セキュアでレジリエントな AI システム導入のためのベストプラクティス)」 (オーストラリアサイバーセキュリティセンター)

- Adversarial attacks on AI models are rising: what should you do now? (AI モデルへの敵対的攻撃が増加: 今何をすべきか?) (VentureBeat)

- 「OWASP AI Security and Privacy Guide (OWASP AI セキュリティ・プライバシーガイド)」(OWASP)

- 「How to manage generative AI security risks in the enterprise (企業における生成 AI のセキュリティリスクを管理する方法)」 (TechTarget)

3 - ETSI が AI セキュリティのグローバル標準を公開

欧州電気通信標準化機構 (ETSI) は 4 月、AI モデルや AI システムを保護する適切な方法の明確化を図るため、AI システムのライフサイクル全体をカバーするよう設計された AI セキュリティのグローバル標準を公表しました。

開発者、ベンダー、オペレーター、インテグレーター、バイヤーなどといった AI 関係者を対象とする ETSI の技術仕様書「Securing Artificial Intelligence (SAI); Baseline Cyber Security Requirements for AI Models and Systems (人工知能の保護 (SAI) 、AI モデルとシステムのベースラインサイバーセキュリティ要件)」は、AI システムのライフサイクル全体に関する一連の基本的なセキュリティ原則の概要をまとめたものです。

英国 国家サイバーセキュリティセンター (NCSC) および英国 科学・イノベーション・技術省 (DSIT) と協力して作成されたこの仕様書では、AI システムのセキュリティを 5 つの主要段階と 13 のセキュリティ基本原則に分類しています。

- 安全な設計の段階

- AI セキュリティの脅威とリスクについての認識を高めます。

- セキュリティだけでなく、機能性やパフォーマンスも考慮して AI システムを設計します。

- AI システムに対する脅威を評価し、リスクを管理します。

- 人間が AI システムを監督できるようにします。

- 安全な開発の段階

- 資産を特定、追跡、保護します。

- インフラのセキュリティを確保します。

- サプライチェーンのセキュリティを確保します。

- データ、モデル、プロンプトを文書化します。

- 適切なテストと評価を実施します。

- 安全なデプロイメントの段階

- エンドユーザーおよび影響を受けるエンティティに関連するコミュニケーションおよびプロセス。

- 安全な保守の段階

- 定期的なセキュリティアップデート、パッチ適用、緩和策を実施します。

- システムの挙動を監視します。

- 安全な使用終了の段階

- データとモデルの廃棄を確実に行います。

- データとモデルの廃棄を確実に行います。

13 のセキュリティ原則のそれぞれは、より詳細な要件を示す複数の規定によってさらに拡張されています。

例えば、ETSI は「安全な保守」の段階で、AI システムの大規模なアップデートについて、AI モデルの新バージョンと同様にテストおよび評価することを開発者に求めています。 また、この段階では、システム運用者も異常や侵害などのセキュリティ問題を検出するために、システムやユーザーのログを分析する必要があります。

さらに詳細な技術的情報が必要な場合は、73 ページに及ぶ付属レポート「Securing Artificial Intelligence (SAI): Guide to Cyber Security for AI Models and Systems (人工知能の保護 (SAI): AIモデルおよびシステムのためのサイバーセキュリティガイド)」で、それぞれの項目についての詳細な情報が豊富に提供されています。

NCSC のブログによると、技術仕様書と技術レポートを併せて使用することで、「進化するサイバー脅威から AI システムを保護するのに役立つ一連の強固なベースラインセキュリティ要件を、AI サプライチェーンのステークホルダーに提供」できるといいます。

AI セキュリティのベストプラクティスの詳細については、Tenable の以下のブログをご覧ください。

- 「Securing the AI Attack Surface: Separating the Unknown from the Well Understood (アタックサーフェスのセキュリティ対策: よく理解されているものと未知なるものを区別する」

- 「Do You Think You Have No AI Exposures? Think Again (AI エクスポージャーがないと思っていませんか? 考え直してください)」

- 「生成型 AI で脅威をより早く検知、分析、対応する」

- 「Never Trust User Inputs -- And AI Isn't an Exception: A Security-First Approach (セキュリティ第一のアプローチ: ユーザー (AI も含む) の入力を決して信用しない)」

- 「AI セキュリティの ベストプラクティス、調査、洞察」

4 - 調査: オープンソースの AI がサイバーリスクの懸念を引き起こす

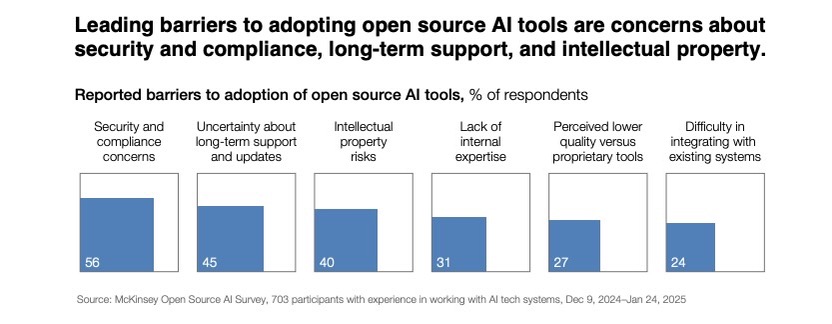

オープンソースの AI テクノロジーを採用する組織が増える中で、 オープンソースの AI が独自の AI 製品よりも高いリスクをもたらすことへの懸念も高まっています。

これは、McKinsey、Patrick J. McGovern 財団、Mozilla が 700 人以上の技術リーダーや上級開発者を対象に実施した世界的な調査に基づく報告書「Open source technology in the age of AI (AI 時代のオープンソース技術)」に記載されています。

具体的には、回答者はオープンソースの AI ツールのコストの低さや使いやすさといったメリットを挙げる一方で、これらのツールはサイバーセキュリティやコンプライアンス、知的財産といった分野ではリスクが高いと答えています。

組織がオープンソース AI 製品を検討中、またはすでに導入している場合には、4 月に発行されたレポートで紹介されている、リスク軽減のための以下の推奨事項をご確認ください。

- 強力なガードレールを導入する: 自動コンテンツフィルタリング、入力と出力の検証、そして何より重要な人による監視について検討する。

- 一貫した方法で評価する: 標準化ベンチマークを使用して、定期的なリスク評価を実施する。

- 信頼できるゾーンで実行する: AI モデルを信頼できる実行環境で実行することで、モデルの安全性を維持する。

- リポジトリを強化する: 強力なアクセス制御でモデルリポジトリを保護する。

- ネットワークをセグメント化する: トレーニングサーバーと推論サーバー用に別々のネットワークを作成する。

- 信頼性を確認する: 暗号ハッシュ検証を使用することで、モデルが信頼できるリポジトリから取得されたことを常に確認する。

オープンソース AI のサイバーセキュリティについては、こちらをご覧ください。

- 「Predictions for Open Source Security in 2025: AI, State Actors, and Supply Chains (2025 年のオープンソースセキュリティの予測: AI、国家アクター、サプライチェーン)」(OpenSSF)

- 「Frequently Asked Questions About DeepSeek Large Language Model (DeepSeek 大規模言語モデル (LLM) に関するよくある質問)」(Tenable)

- 「Mapping the Open-Source AI Debate: Cybersecurity Implications and Policy Priorities (オープンソース AI 論争をマッピング: サイバーセキュリティの意味とポリシーの優先順位」(R Street)

- 「With Open Source Artificial Intelligence, Don’t Forget the Lessons of Open Source Software (オープンソース人工知能を使用するならば、オープンソースソフトウェアの教訓を忘れずに)」 (CISA)

- 「Open Source AI Models: Perfect Storm for Malicious Code, Vulnerabilities (オープンソース AI モデル: 悪意あるコードと脆弱性のパーフェクトストーム)」(DarkReading)

5 - Tenable: クラウドで AI を利用する組織は厄介なサイバーリスクに直面する

クラウド環境で AI ツールを使用している場合は、 AI とクラウドを組み合わせることで生じる複雑なサイバーセキュリティリスクを組織が認識し、それに対して備えていることを確認してください。

これは、3 月に発表された「Tenable クラウド AI リスクレポート 2025」の重要なメッセージであり、Tenable 製品を使用してスキャンされたパブリッククラウドおよびエンタープライズワークロードのテレメトリの分析に基づいています。

「クラウドセキュリティ対策は、AI の新しい課題に対応できるように進化して、一方では AI データに対する複雑な攻撃に対抗し、他方では責任ある AI 改革を実践するという、微妙なバランスを提供しなければなりません」と、Tenable の製品および研究担当 VP である Liat Hayun は声明で述べています。

主要な調査結果は以下の通りです。

- AI ソフトウェアがインストールされているクラウドワークロードの 70% に重大な脆弱性が少なくとも 1 つ発見されています。AI ソフト未使用のクラウドワークロードの場合は 50% です。

- 組織の 77% が、Google Vertex AI Notebook 内にデフォルトで過剰権限が付与されている Compute Engine のサービスアカウントを保有しています。そのため、このデフォルトの Compute Engine に構築されたすべてのサービスがリスクにさらされます。

- Amazon Sagemaker を使用している組織の 91% では、少なくとも 1 つのノートブックインスタンスに、リスクのあるルートアクセスのデフォルト設定が存在します。

以下は、レポートで紹介されたリスク緩和に関する推奨事項の一部です。

- 文脈を踏まえたアプローチで、クラウドインフラ、アイデンティティ、データ、ワークロード、AI ツールにわたるエクスポージャーを明らかにします。

- ビジネスクリティカルな資産に関連するすべての AI コンポーネントを機密情報として分類し、AI ツールとデータを資産インベントリに含めて継続的にスキャンします。

- 最新の AI 規制やガイドラインを常に把握し、主要なクラウドベースの AI データストアをマッピングし、必要なアクセス制御を実装することで、コンプライアンスを維持します。

- クラウドプロバイダーが AI サービスに対して推奨する設定を適用します。ただし、デフォルト設定は一般的に安全ではなく、ガイダンスはまだ進化中であることに注意する必要があります。

- クラウドベースの AI モデルおよびデータストアへの、不正アクセスや過剰な権限によるアクセスを防止します。

- 組織にとって最大のリスクとなる CVE を把握し、脆弱性修正の優先順位を決定します。

詳細は以下をご覧ください。

- 「Tenable クラウド AI リスクレポート 2025」全文

- オンデマンドウェビナー「クラウド AI リスクレポート 2025: クラウドでの、より安全な AI モデルの構築を支援」

- ブログ「クラウド環境の AI セキュリティリスクなんて怖くない!?」

6 - SANS: AI システムを保護するための 6 つの重要な管理

SANS Institute も、サイバーディフェンダーが AI セキュリティのスキルと戦略を開発できるよう支援する活動を開始し、3 月に AI システムセキュリティについてのガイドライン草案を公開しました。

この「SANS Draft Critical AI Security Guidelines v1.1 (SANS 重要 AI セキュリティガイドラインの草案)」は、AI システムのサイバーリスクを軽減するための 6 つの主なセキュリティ管理カテゴリーの概要を示しています。

- アクセス制御方法の具体例を以下に挙げます。

- 最小権限: ユーザー、API、システムが AI システムに必要最小限のアクセスしかできないようにする

- ゼロトラスト: AI モデルとのすべてのやりとりを精査する

- API モニタリング: 悪意のある可能性がある API の使用にフラグを立てる

- AI の運用データとトレーニングデータの保護の具体例を以下に挙げます。

- AI モデルのデータの完全性

- AI プロンプトの改ざん防止

- 安全なデプロイメント方法の決定の具体例を以下に挙げます。

- 予期されるパフォーマンスや規制要件などの基準に基づき、オンプレミスとクラウドを比較

- API キーやアルゴリズムなどの機密情報を公開しない、大規模言語モデル (LLM) と統合された開発環境

- 悪意のある入力攻撃を防ぐための推論セキュリティの具体例を以下に挙げます。

- AI の出力に対する応答ポリシーの採用

- プロンプトインジェクション攻撃を軽減するためのプロンプトのフィルタリングと検証

- AI モデルの継続的なモニタリングの具体例を以下に挙げます。

- 不適切なクエリの拒否

- 不正なモデル変更の検出

- プロンプトと出力のログ記録

- データ保護およびプライバシー規制に準拠するためのガバナンス、リスク、コンプライアンスの具体例を以下に挙げます。

- AI リスク管理フレームワークの導入

- AI サプライチェーンの依存関係を追跡するための AI 部品表の管理

- AI モデルのライフサイクルを追跡するためのモデル登録の使用

この文書には「セキュリティとコンプライアンスを優先することで、組織はこの複雑で進化し続ける環境において、AI を活用したイノベーションの有効性と安全性を保つことができます」と記載されています。

SANS は、6 つの重要なセキュリティ管理策に加えて、AI モデルの導入に関するアドバイスも提供しています。そして重要ではないシステムから始めて徐々に段階的に導入すること、中心となる AI ガバナンス委員会を設立すること、AI インシデント対応計画を策定することを推奨しています。

AI のセキュリティ管理について詳しくは、以下をご参照ください。

- 「The AI Supply Chain Security Imperative: 6 Critical Controls Every Executive Must Implement Now (AI サプライチェーンセキュリティの急務: エグゼクティブが今すぐ導入すべき 6 つの重要なコントロール」(Coalition for Secure AI)

- 「OWASP AI Exchange」(OWASP)

- 「AI Safety vs. AI Security: Navigating the Commonality and Differences (AI の安全性と AI のセキュリティ: 共通点と相違点の解説)」(Cloud Security Alliance)

- 「The new AI imperative is about balancing innovation and security (新たな AI の課題は、イノベーションとセキュリティのバランスを取ること)」(世界経済フォーラム)

- 「AI Data Security (AI データセキュリティ)」 (オーストラリアサイバーセキュリティセンター)

- 「The Rocky Path of Managing AI Security Risks in IT Infrastructure (IT インフラにおける AI セキュリティリスク管理の険しい道のり)」(Cloud Security Alliance)

- Cloud

- Cybersecurity Snapshot